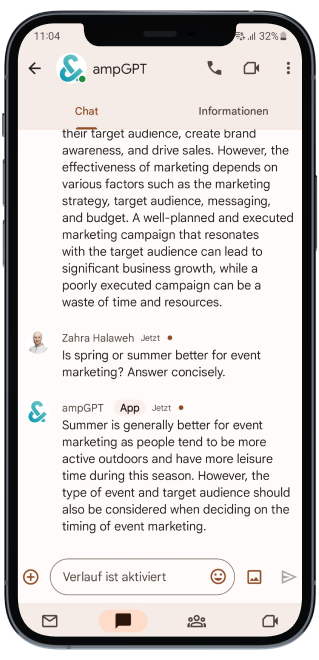

Ein LLM-Chatbot mit Fokus auf Datenschutz

ampGPT ist ein LLM-Chatbot, bei dem Datenschutz an erster Stelle steht und direkt in die vertrauten Arbeitstools Google Chat integriert ist. Er basiert auf Azure OpenAI GPT und bietet leistungsstarke Funktionen und gewährleistet gleichzeitig den Datenschutz. Der Chatbot kann Informationen aus verschiedenen Dateien abrufen, einschließlich interner Unternehmensressourcen.

Kunde

KMU

Typ

Chatbot

Industrie

Productivity Tools

Dauer

2 Monate

Land

Österreich

Festlegung klarer Ziele für AmpGPT

1

Datenschutz sicherstellen

Unser Hauptziel war es, ein Tool zu entwickeln, das unseren Datenschutzstandards entspricht und die sensiblen Daten unserer Kunden schützt.

2

Unternehmensspezifische Daten verarbeiten

Wir konzentrierten uns auf die Implementierung der Funktionen, die unser Projekt zum Erfolg führen würden, einschließlich der Möglichkeit, auf Daten in Google Drive oder Confluence zuzugreifen. Wir haben auch interne Ressourcen identifiziert, die für unser Projekt wichtig waren, und sie ebenfalls integriert.

3

Produktivität steigern

Durch die Automatisierung des Abrufs von Informationen aus verschiedenen Dateien und Dokumenten können sich hochqualifizierte Mitarbeiter auf ihre Kernaufgaben konzentrieren.

ampGPT erstellen

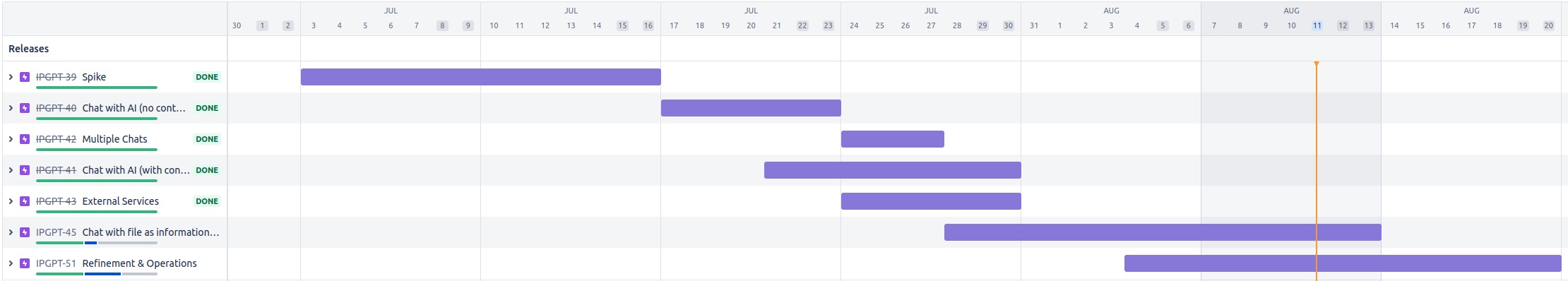

ampGPT wurde in einem strukturierten und systematischen Prozess entwickelt, der drei Phasen durchlief: Skizzieren, Entwickeln und Veröffentlichen.

Um einen optimierten Projektmanagementprozess zu gewährleisten und unsere Zeitplanziele zu erreichen, führten wir eine detaillierte Planung durch, um die Fertigstellung innerhalb eines Zeitrahmens von zwei Monaten sicherzustellen, ohne Kompromisse bei der Qualität einzugehen.

Wir nutzten Jira, unsere bevorzugte Projektmanagement-Lösung, um eine umfassende Roadmap zu erstellen, die die Fortschrittsüberwachung, Aufgabenzuweisung und eine reibungslose Zusammenarbeit ermöglichte. Dieser Ansatz führte zu einer reibungslosen und effizienten Entwicklungsreise.

Phase 1

Skizzieren

Kickoff Workshop

Unsere Entwurfsphase war ein wichtiger Bestandteil des Softwareentwicklungsprozesses, der darauf abzielte, eine qualitativ hochwertige und effektive Lösung zu liefern. Während des Kickoff Workshops arbeiteten wir mit den Stakeholdern zusammen, um ihre Vision, Anforderungen und gewünschten Ergebnisse zu ermitteln. Wir führten eingehende Diskussionen, um ein tiefes Verständnis ihrer Bedürfnisse, Präferenzen und Einschränkungen zu erlangen, das als Grundlage für unseren Entscheidungsprozess dienen sollte.

Roadmap

Zuordnung von User-Storys

Unternehmensziele

Aufgaben, die erledigt werden müssen

Feature-Brainstorming

Benutzer-Personas

.webp)

Architektur-Diagramm

Um Stakeholdern und Entwicklern die Architektur unserer Software effektiver zu vermitteln, wollten wir ein klares und übersichtliches Diagramm erstellen, das verschiedene Abstraktionsebenen zusammenfasst. Wir haben das etablierte C4-Modell als Ansatz für den Entwurf und die Dokumentation unserer Softwarearchitektur gewählt. Mithilfe dieses Modells konnten wir ein Architekturdiagramm erstellen, das die verschiedenen Aspekte unserer Software genau erfasst und die Kommunikation mit anderen erleichtert.

Phase 2

Entwickeln

Technologie Stack

Unser Tech-Stack besteht aus verschiedenen Komponenten, von denen jede eine entscheidende Rolle dabei spielt, die sichere und zuverlässige Funktionalität unserer Lösung zu gewährleisten. Wir haben die eingebetteten Server und Authentifizierungsclients von Spring Boot aufgrund ihrer Funktionen verwendet und unseren Server in Azure gehostet. Dabei nutzten wir die skalierbare und zuverlässige Infrastruktur, um den Benutzeranforderungen gerecht zu werden. Darüber hinaus verhindern wir durch den Einsatz von LangChain eine Anbieterbindung, was uns die Flexibilität gibt, mit zukünftigen KI-Fortschritten Schritt zu halten und in einer sich ständig weiterentwickelnden Technologielandschaft agil zu bleiben.

Spring Boot

Google Chat

LangChain

OpenAI

Microsoft Azure

Umsetzung: Agilität in Aktion

Um sicherzustellen, dass unsere Softwarelösung zuverlässig und fehlerfrei ist, verwendeten wir einen testgetriebenen Entwicklungsansatz (TDD). Dies beinhaltete das Schreiben automatisierter Tests, bevor der Code geschrieben wurde. Dabei wurde sichergestellt, dass der Code die Anforderungen erfüllte und die Tests bestand, bevor er in das System integriert wurde. Durch den Einsatz von TDD waren wir in der Lage, Fehler früh im Entwicklungsprozess zu erkennen und so den Zeit- und Arbeitsaufwand für das Testen und Debuggen zu reduzieren.

Für unsere Implementierung verwendeten wir das Jira Kanban Board, das es uns ermöglichte, an mehreren Aspekten des Projekts gleichzeitig zu arbeiten. Die Boards ermöglichten es unserem Team, den Arbeitsfluss in verschiedenen Phasen zu visualisieren und zu verwalten, sodass wir verschiedene Aufgaben parallel bearbeiten konnten. Durch den Einsatz von Kanban-Boards in Jira konnten wir den Fortschritt jeder Aufgabe verfolgen, Engpässe visualisieren und Bereiche identifizieren, in denen wir unseren Entwicklungsprozess verbessern könnten.

Wir haben die Stakeholder regelmäßig auf dem Laufenden gehalten und Feedback gegeben, um sicherzustellen, dass wir ihre Anforderungen und Erwartungen erfüllen. Dies trug dazu bei, sicherzustellen, dass wir ein Produkt lieferten, das ihren Bedürfnissen entsprach und ihnen einen erheblichen Wettbewerbsvorteil verschaffte.

Einzigartige App, einzigartige Herausforderungen

Bewältigung der Komplexität von KI-Modellen

Angesichts der zahlreichen verfügbaren Modelle kann die Auswahl des richtigen Modells eine schwierige Aufgabe sein, die durch die Notwendigkeit der Feinabstimmung verschiedener Parameter für eine optimale Leistung noch schwieriger wird. Dies zu erreichen, kann ein zeitintensiver Prozess sein, der ein tiefes Verständnis der zugrunde liegenden Algorithmen und ihrer Feinheiten erfordert.

Nahtlose Integration interner Daten

Die Integration von KI-Modellen in bestehende Softwaresysteme kann ein komplexer und herausfordernder Prozess sein, der ein gründliches Verständnis der zugrunde liegenden Architektur erfordert, um potenzielle Kompatibilitätsprobleme zu vermeiden. Darüber hinaus kann die Integration mit internen Datenquellen wie Dateien in unserem Google Drive oder Confluence die Komplexität des Integrationsprozesses weiter erhöhen. Dies erfordert sorgfältige Überlegungen und Fachwissen, um eine nahtlose und erfolgreiche Integration zu gewährleisten.

Der Konkurrenz einen Schritt voraus sein

Das KI-Ökosystem ist ein sich schnell entwickelnder und dynamischer Raum, in dem regelmäßig neue SDKs, Bibliotheken und Techniken auftauchen. Mit den neuesten Entwicklungen Schritt zu halten und zu entscheiden, was aufgenommen und was weggelassen werden soll, kann sich als schwierige Aufgabe erweisen. Daher ist es wichtig, über die neuesten Entwicklungen auf dem Laufenden zu bleiben und unsere Strategien kontinuierlich zu evaluieren und anzupassen, um sicherzustellen, dass wir die effektivsten und effizientesten verfügbaren Tools und Techniken nutzen.

Gewährleistung der Vertraulichkeit

Um den Datenschutzbedenken unserer Stakeholder Rechnung zu tragen, haben wir das gehostete GPT-Modell von Azure verwendet, das eine hervorragende Grundlage für unser Chatbot-Projekt bot. Die Datenschutzrichtlinie von Azure stellt sicher, dass alle Eingaben, Ausgaben, Embeddings und Trainingsdaten vor dem Zugriff durch andere Kunden, OpenAI, Microsoft oder Produkte oder Dienste von Drittanbietern geschützt sind.

Lesen Sie mehr über die Datenschutzrichtlinie von Azure in ihrer Dokumentation

Phase 3

Veröffentlichen

KI zum Leben erwecken

Um sicherzustellen, dass die Benutzer das volle Potenzial des Chatbots effektiv nutzen können, haben wir umfassende Schulungsmaterialien und Schulungsressourcen bereitgestellt. Diese Materialien wurden entwickelt, um Benutzern zu helfen, schnell zu verstehen, wie sie den Chatbot verwenden und seine Funktionen voll ausschöpfen können. Seit der Veröffentlichung des Chatbots haben wir überwältigend positives Feedback von Mitarbeitern erhalten, die ihn häufig zur Unterstützung ihrer täglichen Aufgaben genutzt haben. Dieser hohe Nutzungsgrad hat uns wertvolle Einblicke und Feedback geliefert, sodass wir die Leistung des Chatbots kontinuierlich verbessern und ihn besser an die sich ändernden Bedürfnisse unserer Benutzer anpassen können. Durch die Nutzung dieses Feedbacks sind wir in der Lage, eine nahtlosere und effektivere Benutzererfahrung zu bieten und den Wert des Chatbots für unsere Kunden weiter zu steigern.

Wirkung entfesselt

Zusammenfassung

In nur zwei Monaten haben wir ampGPT entwickelt, das es allen Mitarbeitern ermöglicht, leichter fundierte Entscheidungen zu treffen, ohne die Sicherheit der Unternehmensdaten zu gefährden. Dies wurde durch die Integration mehrerer moderner Technologien ermöglicht.

Auswirkung

ampGPT hat das Informationsmanagement und den Informationszugriff verbessert, indem es eine sichere Lösung für das Abrufen von Daten und das Beantworten von Routineanfragen bietet. ampGPT nutzt natürliche Sprachverarbeitung und maschinelles Lernen und ermöglicht es Mitarbeitern, Informationen bei Bedarf schnell und einfach abzurufen, ohne dass spezielle Schulungen oder technisches Fachwissen erforderlich sind. Das Ergebnis ist eine agilere, reaktionsschnellere und effizientere Belegschaft, die sich an sich ändernde Geschäftsanforderungen und neue Möglichkeiten anpassen kann.

Über &

& nutzt die Macht der Technologie, um Menschen bei dem zu unterstützen, was sie tun. Je nach Ihren Ideen und Bedürfnissen entwickeln, gestalten und verbessern wir Softwareprodukte, um Ihre digitale Präsenz zu stärken.

Sind Sie bereit, Ihr Unternehmen mit innovativen Softwarelösungen zu transformieren?

Bei & setzen wir uns leidenschaftlich dafür ein, Ihre Ideen in die Realität umzusetzen und außergewöhnliche Softwarelösungen zu liefern, die Ihren individuellen Anforderungen entsprechen.